适配多个训练、推理框架。

适配主流模型续训、微调、推理。

适配主流国产GPU芯片。

支持同一集群不同GPU卡资源、不同集群不同GPU卡资源、长距离(1000km内)跨域GPU卡资源混合训练。

支持不同集群、不同区域GPU卡资源混合推理。

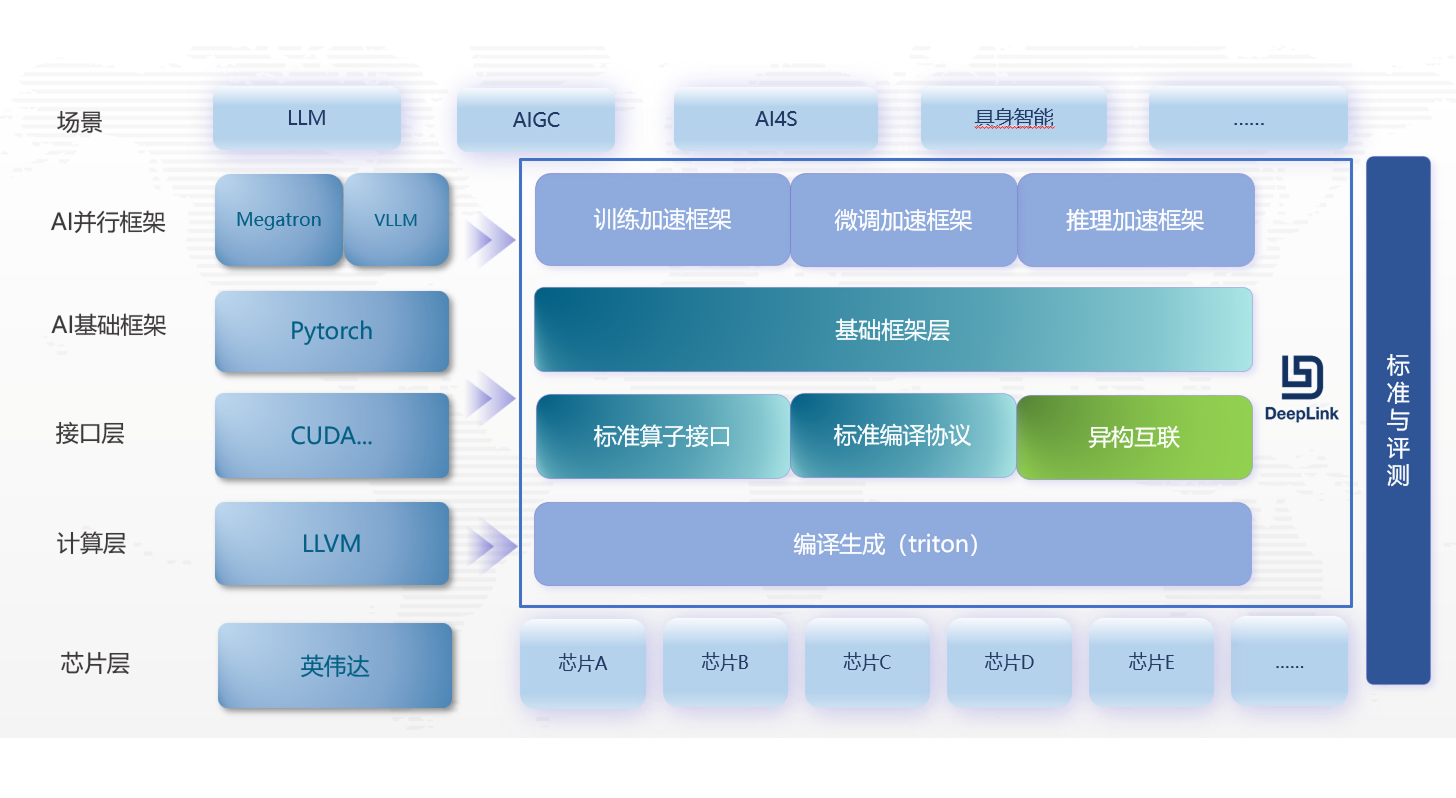

多芯片通用框架:设备无关 torch,可屏蔽各硬件厂商的 torch 差异,为用户提供一致使用体验。

标准算子接口:提供统一的标准算子接口,涵盖大模型、分类、检测、分割及姿态估计等多个领域深度学习模型所需训练算子。

标准编译框架:提供易用、高效的一站式编译适配流程,灵活支持AI硬件图编译器的特性,提高芯片适配效率。

将不同算力、品牌的芯片共同组成更大的计算集群、或跨域集群,进行AI训练任务。在大模型算力上可综合更多算力,降低集群成本。

主要技术核心包括:异构芯片的通信打通和异构互联的并行训练策略。

支持张量/序列/数据/流水线/上下文/优化器6D混合并行,实现训练加速、微调加速、推理加速和算子生成等多种场景。

提供丰富的实例类型,面向各类企业应用场景

商汤大装置 SenseCore AI 云原生平台融合 DeepLink 方案,全面优化异构算力混合调度、大模型训练和推理加速能力, 并支持智算中心、专有云、私有云独立部署,提升GPU使用效率,为用户提供统一、高效、易用的使用体验。